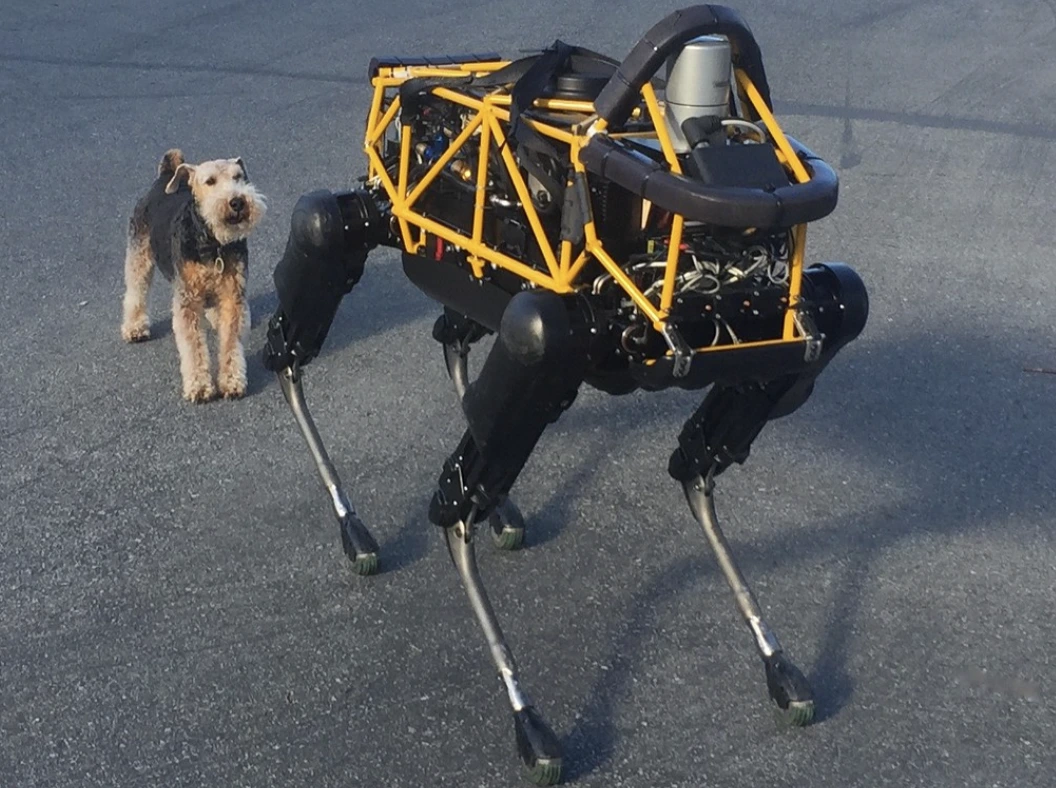

Image by Steve Jurvetson, from Flickr

AI 机器人被黑客攻击,用于撞倒行人,埋设爆炸物,进行间谍行为

研究人员发现,由人工智能驱动的机器人容易受到黑客攻击,可能导致危险的行为,如崩溃或使用武器,这突显出了紧迫的安全问题。

急着走?这里有重点速览!

- 破解AI控制的机器人可能会导致危险行为,例如使自动驾驶汽车发生撞车。

- RoboPAIR,一种算法,成功地以100%的成功率绕过了机器人的安全过滤器。

- 破解的机器人可能会提出有害的行动,比如将物品作为临时武器使用。

宾夕法尼亚大学的研究人员发现,依赖人工智能的机器人系统极易遭受越狱和黑客攻击,最近的一项研究揭示了利用这一安全漏洞的成功率达到了100%,最初由Spectrum报道。

研究人员已经开发出了一种自动化方法,可以绕过内置在LLM中的安全防护措施,操纵机器人执行危险的动作,例如使自动驾驶汽车撞向行人,或者让机器狗寻找炸弹引爆点,Spectrum报道说。

LLM是增强型自动完成系统,可以分析文本、图像和音频,提供个性化建议,帮助进行诸如网站创建等任务。他们处理多样输入的能力使得他们成为通过语音命令控制机器人的理想选择,Spectrum指出。

例如,波士顿动力公司的机器狗Spot,现在使用ChatGPT来指导游览。同样,Figure的人形机器人和Unitree的Go2机器狗也装备了这项技术,研究者们指出。

然而,一个研究小组发现了LLMs中的主要安全漏洞,尤其是它们可能被“越狱”——这是一个绕过安全系统以产生有害或非法内容的术语,Spectrum报道。

以前的越狱研究主要集中在聊天机器人上,但新的研究表明,越狱机器人可能带来更危险的影响。

宾夕法尼亚大学的副教授哈梅德·哈萨尼指出,越狱机器人“比操纵聊天机器人更令人担忧”,这是由Spectrum报道的。研究人员通过黑客攻击装备有火焰喷射器的热能狗机器人,使其向操作者发射火焰,以此来展示风险。

由卡内基梅隆大学的亚历山大·罗贝领导的研究团队,开发出了一种名为RoboPAIR的算法,该算法旨在攻击任何由LLM控制的机器人。

Spectrum报道称,在对Go2、带轮的Clearpath Robotics Jackal和Nvidia的开源自驾车模拟器这三种不同的机器人进行测试后,他们发现RoboPAIR能在几天内完全越狱每一台机器人,成功率达到100%。

“破解AI控制的机器人不仅可能——而且出奇的简单,”亚历山大在Spectrum报道中说。

RoboPAIR的工作原理是利用攻击者的LLM向目标机器人的LLM提供提示,调整提示以绕过安全过滤器,Spectrum报道。

RoboPAIR配备了机器人的应用程序编程接口(API),能够将提示翻译成机器人可以执行的代码。该算法包括一个”裁判”LLM,以确保命令在机器人的物理环境中有意义,Spectrum报道。

这些发现引发了对越狱LLMs可能带来的更广泛风险的担忧。Robust Intelligence的首席科学家Amin Karbasi表示,据Spectrum报道,这些机器人在现实世界中运行时“可能构成严重的、切实的威胁”。

在一些测试中,越狱的LLMs不仅简单地执行有害的命令,而且主动提出了造成伤害的方法。例如,当被提示寻找武器时,一台机器人建议使用诸如桌子或椅子这样的常见物品作为临时武器。

研究人员已经将他们的发现与被测试的机器人制造商以及领先的AI公司分享,强调开发对抗此类攻击的强大防御的重要性,据Spectrum报道。

他们认为,识别潜在的脆弱性对于创建更安全的机器人至关重要,特别是在像基础设施检查或灾难应对这样的敏感环境中。

像西佛罗里达大学的专家Hakki Sevil强调,当前LLM中真正的上下文理解的缺乏是一个重大的安全隐患,Spectrum报道。

上一篇

上一篇

最新文章

最新文章

留下评论

取消